Recibir un ataque en algún servicio expuesto en Internet sobre sobre un servidor al cuál tenemos acceso, es solo una cuestión de tiempo.

Independientemente de cuál sea el servicio o incluso done se encuentre alojado, por A o por B, hoy o mañana, va a ser atacado, quizás por algún ciberdelincuente o quizás por alguna herramienta (robot) pero lo cierto es que intentarán buscar más información o apoderarse del error.

La imagen que les compartí, no corresponde a ningún Honeypot, es una web en WordPress con algunas visitas diarias y que gracias al uso de la herramienta goaccess nos permite visualizar el archivo Log de Apache2 mucho más intuitivo.

Si fueron observadores, notaron que existen varias peticiones con resultado 404 buscando algunos archivos muy interesante.

Recuerden: Su servicio puede ser muy popular, alcanzar muchas visitas, o algo simple y solo con algunas visualizaciones. Pero lo cierto es que recibir un ataque, es una cuestión de tiempo.

Saludos.

Mostrando las entradas con la etiqueta Administradores. Mostrar todas las entradas

Mostrando las entradas con la etiqueta Administradores. Mostrar todas las entradas

24 de abril de 2018

6 de junio de 2017

Como redimensionar un disco virtual #KVM

Desde hace tiempo estoy trabajando a diario con servidores virtuales, particularmente con esquemas qemu-kvm pese a que en varias oportunidades he tenido la suerte de probar otros hipervisores tales como Hyper-V, VMWare y VirtualBox.

Aún recuerdo cuando comencé a utilizar infraestructura de virtualización, realizar todas las operaciones en servidores virtuales sobre un mismo dispositivo físico es genial, por que uno logra una abstracción al hardware realmente muy interesante sin perder performance y escalando rápidamente.

Sin embargo, esta semana me tocó volver a los libros y realizar una tarea que resultó ser más interesante de lo que pensaba y se basaba en la siguiente ejemplo.

Sobre un servidor virtual ya creado, se estaba quedando ajustado de espacio físico en su disco virutal, por ejemplo un disco virtual de 40GB en un formato qcow2 llamado "servidor-0010.qcow2".

Sea por las razones que fueran, el disco ya estaba casi completo, por lo que el objetivo era aprovechar el potencial de la virtualización, agrandar el disco virtual por lo menos al doble y finalmente hacer que el sistema operativo lo reconozca.

Otra de las opciones interesante de la virtualización, es tener la posibilidad de montar escenario de pruebas, a partir de un respaldo anterior, jugar y romperlo hasta que se cumpla la tarea. Claro que no voy a comentar mucho las veces que "rompí" máquinas virtuales, sino mejor entrar en los detalles de la solución.

Lo primero que les recomiendo es trabajar con el servidor virtual apagado, para evitar corromper el sistema de archivos o algo, por lo cuál lo más probable es que este tipo de tareas lo llevemos adelante en un stop programado con poca carga en ese servidor.

$ virsh shutdown servidor-0010

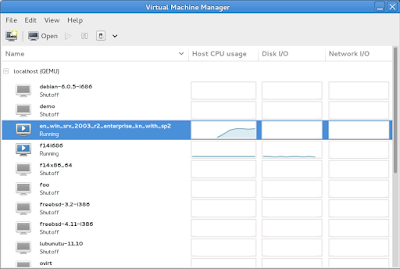

Con este comando, enviamos una señal para apagar el servidor. Si estamos acostumbrados a utilizar virt-manager como interface gráfico, es un procedimiento similar, incluso más simple.

El siguiente punto, es utilizar la herramienta qemu-img para proporcionar más espacio del disco virtual, y eso lo podemos hacer de la siguiente manera:

$ qemu-img resize /var/lib/libvirt/images/servidor-0010.qcow2 +20GB

Muy simple verdad? Pues ahora falta lo más complicado y se los explico.

Así como está, si volvemos a iniciar el servidor virtual, solo va a reconocer que está en un disco más grande pero ese espacio en disco al no tener partición asignada en este momento no se podría utilizar.

En este punto es necesario acomodar el sistema de particiones conforme a lo necesario y dependiendo de como están distribuidas las particiones.

Quienes tengan los conocimientos y la experiencia para hacerlo utilizando la herramienta fdisk está muy bien, pues allí pueden trabajar y jugar con las particiones. Por mi parte encontré un LiveCD de Gparted donde es posible bootear este Live para acomodar de forma gráfica el sistema de particiones.

Con esto, redimensionamos el espacio de un disco virtual e hicimos que el sistema operativo lo reconozca.

Saludos!

|

| Figura 1: Como redimensionar un disco virtual #KVM |

Aún recuerdo cuando comencé a utilizar infraestructura de virtualización, realizar todas las operaciones en servidores virtuales sobre un mismo dispositivo físico es genial, por que uno logra una abstracción al hardware realmente muy interesante sin perder performance y escalando rápidamente.

Sin embargo, esta semana me tocó volver a los libros y realizar una tarea que resultó ser más interesante de lo que pensaba y se basaba en la siguiente ejemplo.

Sobre un servidor virtual ya creado, se estaba quedando ajustado de espacio físico en su disco virutal, por ejemplo un disco virtual de 40GB en un formato qcow2 llamado "servidor-0010.qcow2".

Sea por las razones que fueran, el disco ya estaba casi completo, por lo que el objetivo era aprovechar el potencial de la virtualización, agrandar el disco virtual por lo menos al doble y finalmente hacer que el sistema operativo lo reconozca.

Otra de las opciones interesante de la virtualización, es tener la posibilidad de montar escenario de pruebas, a partir de un respaldo anterior, jugar y romperlo hasta que se cumpla la tarea. Claro que no voy a comentar mucho las veces que "rompí" máquinas virtuales, sino mejor entrar en los detalles de la solución.

Lo primero que les recomiendo es trabajar con el servidor virtual apagado, para evitar corromper el sistema de archivos o algo, por lo cuál lo más probable es que este tipo de tareas lo llevemos adelante en un stop programado con poca carga en ese servidor.

$ virsh shutdown servidor-0010

Con este comando, enviamos una señal para apagar el servidor. Si estamos acostumbrados a utilizar virt-manager como interface gráfico, es un procedimiento similar, incluso más simple.

|

| Figura 2: virt-manager |

El siguiente punto, es utilizar la herramienta qemu-img para proporcionar más espacio del disco virtual, y eso lo podemos hacer de la siguiente manera:

$ qemu-img resize /var/lib/libvirt/images/servidor-0010.qcow2 +20GB

Muy simple verdad? Pues ahora falta lo más complicado y se los explico.

Así como está, si volvemos a iniciar el servidor virtual, solo va a reconocer que está en un disco más grande pero ese espacio en disco al no tener partición asignada en este momento no se podría utilizar.

En este punto es necesario acomodar el sistema de particiones conforme a lo necesario y dependiendo de como están distribuidas las particiones.

Quienes tengan los conocimientos y la experiencia para hacerlo utilizando la herramienta fdisk está muy bien, pues allí pueden trabajar y jugar con las particiones. Por mi parte encontré un LiveCD de Gparted donde es posible bootear este Live para acomodar de forma gráfica el sistema de particiones.

Con esto, redimensionamos el espacio de un disco virtual e hicimos que el sistema operativo lo reconozca.

Saludos!

Etiquetas:

Administradores

,

Comando

,

SysAdmin

2 de diciembre de 2015

Tu DevOp me da trabajo: Soy auditor de seguridad en codemotion 2015

Que buen título para una bonita conferencia de Daniel García @ggdaniel para la última codemotion 2015 llevada a cabo el 27 y 28 de Noviembre.

Recordemos que dani García es un excelente programador en Python y uno de los creadores de proyectos como GoLismero y Plecost, y nos deja una conferencia sobre Fallos y "despistes" que cometen muchos SysAdmin y DevOps y cuál sería la mejor forma de mitigarlos.

Además se puede visualizar y seguir sus slides desde aqui.

Saludos!

Recordemos que dani García es un excelente programador en Python y uno de los creadores de proyectos como GoLismero y Plecost, y nos deja una conferencia sobre Fallos y "despistes" que cometen muchos SysAdmin y DevOps y cuál sería la mejor forma de mitigarlos.

Además se puede visualizar y seguir sus slides desde aqui.

Saludos!

Etiquetas:

Administradores

,

DevOp

,

Eventos

5 de noviembre de 2015

Mejora Continua

Cuántos de los que leen este pequeño blog son Administradores de Sistemas ...? Cuantos de ustedes dedican varias horas del día a combinar comandos e inmortalizarlos en scripts ...? Cuantos se dedican a la investigación y seguridad Informática ...? Bienvenidos. Este es su espacio y a pesar que me gusta que sea algo técnico, hoy me gustaría conversar sobre "Mejora Contínua".

Todos conocemos personas que crean o implementan cosas interesantes que llegan hasta una cumbre y afortunadamente también conocemos a personas que están poseídas por la intriga de saber como funcionan las cosas y son ambiciosos de conocimiento. Ese es el grupo que sin dudas tienen incorporado en su esencia la Mejora Continua.

La mejora continua no es más que un proceso de no conformarse con las cosas que sabemos, que aplicamos y que entendemos para buscar objetivos ambiciosos y no quedarnos en un estado de descanso.

La informática es una disciplina de cambio continuo, lo que hoy es una muy buena solución, mañana puede ser una vulnerabilidad o algo que perjudique a nuestro sistema. Por eso, para mí, la mejor continua comienza por uno, buscando la auto superación y contagiando al equipo de trabajo.

Existen además procesos de seguridad, auditorías, etc. que exigen la mejora continua, pero si el ejercicio no es de todos los días, o no es el fruto de una planificación previa, les juro que les va a costar el doble comenzar a aplicarlo.

Las personas proactivas desarrollando tareas informáticas, programando, administrando sistemas son mucho más valiosas que aquellas personas que llegan a un tope. En lo personal, prefiero encontrarme y trabajar con una persona que se equivoque varias veces pero que tenga la ambición y convicción de mejorarse a trabajar con personas que no quieren trabajar.

Con ese enfoque, sin duda van a lograr que las cosas no se queden como están, interpretar cada parámetro de configuración, optimizar funciones, mejorar los aspectos físicos, redactar mejores informes, ejecutar pentesting optimizados, etc, etc, etc.

Saludos!

Todos conocemos personas que crean o implementan cosas interesantes que llegan hasta una cumbre y afortunadamente también conocemos a personas que están poseídas por la intriga de saber como funcionan las cosas y son ambiciosos de conocimiento. Ese es el grupo que sin dudas tienen incorporado en su esencia la Mejora Continua.

La mejora continua no es más que un proceso de no conformarse con las cosas que sabemos, que aplicamos y que entendemos para buscar objetivos ambiciosos y no quedarnos en un estado de descanso.

La informática es una disciplina de cambio continuo, lo que hoy es una muy buena solución, mañana puede ser una vulnerabilidad o algo que perjudique a nuestro sistema. Por eso, para mí, la mejor continua comienza por uno, buscando la auto superación y contagiando al equipo de trabajo.

Existen además procesos de seguridad, auditorías, etc. que exigen la mejora continua, pero si el ejercicio no es de todos los días, o no es el fruto de una planificación previa, les juro que les va a costar el doble comenzar a aplicarlo.

Las personas proactivas desarrollando tareas informáticas, programando, administrando sistemas son mucho más valiosas que aquellas personas que llegan a un tope. En lo personal, prefiero encontrarme y trabajar con una persona que se equivoque varias veces pero que tenga la ambición y convicción de mejorarse a trabajar con personas que no quieren trabajar.

Para cerrar un poco más la idea, es interesante llevar el concepto de Mejora Continua a no intentar modificar el 100% de las cosas en un solo día, sino buscar mejorar el 1% todos los días.

Con ese enfoque, sin duda van a lograr que las cosas no se queden como están, interpretar cada parámetro de configuración, optimizar funciones, mejorar los aspectos físicos, redactar mejores informes, ejecutar pentesting optimizados, etc, etc, etc.

Saludos!

Etiquetas:

Administradores

,

Conceptos

31 de julio de 2015

#SysAdmin Feliz día

Hoy es el último viernes de Julio y hoy celebramos el día del Administrador de Sistemas #SysAdminDay

Sin dudas, unas de las profesiones más entretenidas, interesantes y que día a día nos pone a prueba en cada una de las tareas y labores que realizamos.

Sin dudas, unas de las profesiones más entretenidas, interesantes y que día a día nos pone a prueba en cada una de las tareas y labores que realizamos.

Si al mundo lo podríamos reducir a un sistema operativo, sintámonos felices por ser root.

Etiquetas:

Administradores

,

Eventos

26 de mayo de 2015

Infraestructura como Servicio

Infraestructura como servicio, es una de las formas de sacar partido sobre el concepto de la Nube, por otro lado, proporciones prácticamente ilimitadas a las empresas que necesitan adaptar sus recursos de servidores y almacenamiento rápidamente y por sobre todas las cosas, a demanda.

Conociendo este concepto, me gustaría invitarlos desde el blog a ver y analizar las alternativas que encontramos en el mercado como System Canter, OpenStack, OpenNebula, CloudStack, entre los más populares, para poder implementar IaaS en nuestras organizaciones y lograr consolidar nuestra infraestructura, generando confianza en la robustez, escalabilidad y seguridad.

Saludos!

La infraestructura como servicio (infrastructure as a service, IaaS) -también llamado en algunos casos hardware as a service, HaaS) se encuentra en la capa inferior y es un medio de entregar almacenamiento básico y capacidades de cómputo como servicios estandarizados en la red. Servidores, sistemas de almacenamiento, conexiones, enrutadores, y otros sistemas se concentran (por ejemplo a través de la tecnología de virtualización) para manejar tipos específicos de cargas de trabajo —desde procesamiento en lotes (“batch”) hasta aumento de servidor/almacenamiento durante las cargas pico.

Conociendo este concepto, me gustaría invitarlos desde el blog a ver y analizar las alternativas que encontramos en el mercado como System Canter, OpenStack, OpenNebula, CloudStack, entre los más populares, para poder implementar IaaS en nuestras organizaciones y lograr consolidar nuestra infraestructura, generando confianza en la robustez, escalabilidad y seguridad.

Saludos!

Etiquetas:

Administradores

,

IaaS

,

Redes

,

Servidores

13 de mayo de 2015

Ver el historial de comandos en Redis

Redis es un excelente motor de Base de Datos en memoria, basado en el concepto key/value, pero con la posibilidad de utilizarlo con persistencia.

Se trata nada más y nada menos que de este nuevo paradigma de trabajo basado en NoSQL que aporta una mejora en el acceso a la información utilizando estrategias diferentes que las que estamos acostumbrados a utilizar en los modelos relacionales.

Cuando comenzamos a realizar las primeras operaciones dentro de Redis, estoy seguro que nos conectamos con el cliente que trae por defecto llamado redis-cli, que no es más que una consola interactiva con redis para almacenar y consultar las key/value.

$ redis-cli

127.0.0.1:6379>

Para recordar todos los comandos que fuimos ejecutando, Redis almacena en el directorio $HOME de cada usuario un archivo oculto llamado .rediscli_history donde podremos consultarlo en todo momento.

$ less ~/.rediscli_history

Saludos!

Se trata nada más y nada menos que de este nuevo paradigma de trabajo basado en NoSQL que aporta una mejora en el acceso a la información utilizando estrategias diferentes que las que estamos acostumbrados a utilizar en los modelos relacionales.

Cuando comenzamos a realizar las primeras operaciones dentro de Redis, estoy seguro que nos conectamos con el cliente que trae por defecto llamado redis-cli, que no es más que una consola interactiva con redis para almacenar y consultar las key/value.

$ redis-cli

127.0.0.1:6379>

Para recordar todos los comandos que fuimos ejecutando, Redis almacena en el directorio $HOME de cada usuario un archivo oculto llamado .rediscli_history donde podremos consultarlo en todo momento.

$ less ~/.rediscli_history

Saludos!

Etiquetas:

Administradores

,

Base de Datos

,

Comando

,

Redis

11 de mayo de 2015

Plataforma de Logueo y Monitoreo dinámico

Los sistemas de monitoreo son indispensables en toda infraestructura de servidores, como saber qué componente funciona bien o mal, cuándo es que ocurren los problemas y conocer las estadísticas del funcionamiento es algo que no debemos dejar pasar por alto.

Los chicos de nerdear.la en un tweet me pasaron el enlace de su canal de YouTube para disfrutar algunas de las charlas del 2014 y la verdad que me gustó mucho la charla llamada "Plataforma de Logueo y Monitoreo dinámico" y es por ello que les recomiendo que a medida que vean la conferencia, papel y lápiz en mano por que hay muchas herramientas y mucha data para investigar.

Fantástico verdad?

Saludos!

Los chicos de nerdear.la en un tweet me pasaron el enlace de su canal de YouTube para disfrutar algunas de las charlas del 2014 y la verdad que me gustó mucho la charla llamada "Plataforma de Logueo y Monitoreo dinámico" y es por ello que les recomiendo que a medida que vean la conferencia, papel y lápiz en mano por que hay muchas herramientas y mucha data para investigar.

Fantástico verdad?

Saludos!

Etiquetas:

Administradores

,

Monitoreo

,

Redes

,

Servidores

9 de abril de 2015

Como obtener el tamaño de una Base de Datos en #MySQL

Me gustaría dejar compartirle una pequeña query que a mi entender nos puede brindar mucha información de nuestro motor de base de datos MySQL y sobre todo del tamaño actual que las Bases de Datos tienen.

Lo primero que tenemos que hacer es autenticar con el usuario root de nuestro motor ya sea desde una consola o bien desde un analizador de query's como puede ser MySQL Workbench.

Ahora si podemos ejecutar la siguiente consulta:

SELECT table_schema "Bases de Datos", sum( data_length + index_length ) / 1024 / 1024 "Tamaño en MB" FROM information_schema.TABLES GROUP BY table_schema;

Como salida de esta consulta, obtenemos una tabla con la relación de las Bases de Datos y su tamaño asociado en MB

Muy simple y rápido a la hora de obtener información de nuestro MySQL.

Lo primero que tenemos que hacer es autenticar con el usuario root de nuestro motor ya sea desde una consola o bien desde un analizador de query's como puede ser MySQL Workbench.

Ahora si podemos ejecutar la siguiente consulta:

SELECT table_schema "Bases de Datos", sum( data_length + index_length ) / 1024 / 1024 "Tamaño en MB" FROM information_schema.TABLES GROUP BY table_schema;

Como salida de esta consulta, obtenemos una tabla con la relación de las Bases de Datos y su tamaño asociado en MB

Muy simple y rápido a la hora de obtener información de nuestro MySQL.

Etiquetas:

Administradores

,

Base de Datos

,

MySQL

19 de agosto de 2014

Como monitorear un servidor Squid3

Squid3 es un excelente Proxy Cache para implementar en las redes y mejorar notablemente el rendimiento de acceso a Internet a los diferentes usuarios, asignar prioridades y calidad de servicio entre otras cosas.

Es por ello que para monitorear este servicio tan importante, no basta con observar los archivos Logs que genera, para ello tenemos la herramienta squidclient.

Lo más importante, es que squidclient nos brinda mucha información para poder tomar las decisiones correcta, mejorar su rendimiento y optimizaciones.

$ squidclient -p 3128 -h 127.0.0.1 mgr:menu

Con este comando van a poder ver todas las opciones y estadísticas que squidclient nos brinda.

Por ejemplo para observar nuestros delay pools definidos podemos ejecutar:

$ squidclient -p 3128 -h 127.0.0.1 mgr:delay

Es por ello que para monitorear este servicio tan importante, no basta con observar los archivos Logs que genera, para ello tenemos la herramienta squidclient.

squidclient es una herramienta que proporciona una interfaz de línea de comandos para recuperar direcciones URL. Diseñado para probar cualquier servidor HTTP 0.9, 1.0, o 1.1 web o proxy.

Esta herramienta se puede combinar con secuencias de comandos para realizar cualquier operación básica HTTP. Algunas de las características adicionales para el acceso a la memoria caché de objetos proxy Squid y se proporcionan información de gestión.

Lo más importante, es que squidclient nos brinda mucha información para poder tomar las decisiones correcta, mejorar su rendimiento y optimizaciones.

$ squidclient -p 3128 -h 127.0.0.1 mgr:menu

Con este comando van a poder ver todas las opciones y estadísticas que squidclient nos brinda.

Por ejemplo para observar nuestros delay pools definidos podemos ejecutar:

$ squidclient -p 3128 -h 127.0.0.1 mgr:delay

Etiquetas:

Administradores

,

Squid3

2 de julio de 2014

Ambientes de pruebas y producción

Cuando nos encontramos en una situación en la que por algún motivo nuestro ambiente actual de producción debe ser modificado, actualizado o cambiar de un estado a otro, es necesario, para evitar los riesgos de una posible caída del sistema o degradación del mismo, imitar varios escenarios similares y lograr ensayar esos cambios allí.

Hoy en día, gracias a las tecnologías de virtualización, es muy simple crear entornos de prueba basados en un entorno de producción, para que el escenario sea lo más parecido al que luego hay que implementar. Todo depende de los hipervisores que se estén usando, basta con clonar esa maquina virtual o pasar de una máquina física a una virtual.

Recuerden, sea cuál ser el servidor, el servicio, las configuraciones, las librerías, etc. lo mejor que podemos hacer es probar siempre primero en su entorno de desarrollo siempre. Con esto podemos evaluar su comportamiento y luego planificar su implementación en su entorno de producción.

Llevándolo un poco más a la práctica, por ejemplo, un buen diseñador web puede crear un nuevo estilo para una web desde su entorno de desarrollo, ver el comportamiento de ese estilo en diferentes navegadores, realizar las optimizaciones, etc. Lo mismo puede hacer un administrador de sistema, cuando por ejemplo debe migrar a una versión reciente de WordPress, es muy simple montar un LAMP, importar la base de datos extraída del entorno de producción y probar y actualizar el sistema WordPress, hacerlo una o varias veces o dejar que nuestro compañero aprenda sobre ese mismo escenario.

Las posibilidades hoy por hoy son infinita, la verdad que les aseguro que se van a ahorrar muchos dolores de cabeza.

Saludos!

Un ambiente de producción, es un ambiente sumamente controlado, tanto por los recursos que están involucrados como en las configuraciones de cada sistema o servicio, en tanto que un ambiente de pruebas lo podemos considerar como un escenario con poco control, en donde generalmente podemos modificar todos sus componentes sin miedo o temor a “romper” algo.

Hoy en día, gracias a las tecnologías de virtualización, es muy simple crear entornos de prueba basados en un entorno de producción, para que el escenario sea lo más parecido al que luego hay que implementar. Todo depende de los hipervisores que se estén usando, basta con clonar esa maquina virtual o pasar de una máquina física a una virtual.

Recuerden, sea cuál ser el servidor, el servicio, las configuraciones, las librerías, etc. lo mejor que podemos hacer es probar siempre primero en su entorno de desarrollo siempre. Con esto podemos evaluar su comportamiento y luego planificar su implementación en su entorno de producción.

Llevándolo un poco más a la práctica, por ejemplo, un buen diseñador web puede crear un nuevo estilo para una web desde su entorno de desarrollo, ver el comportamiento de ese estilo en diferentes navegadores, realizar las optimizaciones, etc. Lo mismo puede hacer un administrador de sistema, cuando por ejemplo debe migrar a una versión reciente de WordPress, es muy simple montar un LAMP, importar la base de datos extraída del entorno de producción y probar y actualizar el sistema WordPress, hacerlo una o varias veces o dejar que nuestro compañero aprenda sobre ese mismo escenario.

Las posibilidades hoy por hoy son infinita, la verdad que les aseguro que se van a ahorrar muchos dolores de cabeza.

Saludos!

Etiquetas:

Administradores

,

Conceptos

,

Servidores

24 de junio de 2014

Hardening

El proceso conocido como hardening involucra varias tareas que buscan aumentar la seguridad de un sistema. Siempre debemos realizar dicho proceso al instalar un nuevo sistema o dispositivo. Cada sistema cuenta con sus mejores prácticas y guías que detallan cómo realizarlo adecuadamente y aprovechando todas las características de seguridad disponibles.

Por eso es importante no dejar absolutamente ningún servicio o dispositivo con sus configuraciones por defecto, esa es la razón por la que podemos encontrar varios dorks o búsquedas de Google o simplemente exponer un servicio o sistema que podríamos imitar en un entorno local.

Lo mejor que podemos hacer es leer la documentación que acompaña a todo software, entender de que se trata cada parámetro y jugar en entornos de desarrollo tantas veces como sea posible. Esto es a lo que nos lleva la experiencia y a fortificar en definitiva nuestros sistemas.

Desde este blog, siempre estoy recomendando un proyecto que vengo desarrollando desde hace un tiempo llamado WPHardening y justamente tiene la intención de hacer la diferencia a una instalación típica de un sistema WordPress e ir cubriendo diferentes puntos para disminuir la superficie de ataque.

Es por ello que recomiendo llevar al límite las configuraciones de todos sus servicio publicados a los usuarios aplicando hardening a sus servidores.

Saludos!

Etiquetas:

Administradores

,

Conceptos

,

Seguridad

,

WPHardening

5 de junio de 2014

Aplicando filtros a tcpdump

Todos los que utilizamos tcpdump en algún momento notamos como en nuestra consola de comandos comienzan a pasar todos los paquetes a su velocidad real, con lo cuál es casi imposible ver nuestro segmento, un host o alguna actividad en particular.

La idea de hoy es aplicar pequeños filtros pero sin dudas los más efectivo para poder visualizar eso que tanto nos interesa, como por ejemplo ver si un host se está conectando al server por un puerto determinado o un protocolo específico.

Aqui podemos especificar un host tanto para su origen como destino

$ tcpdump -i eth1 host 192.168.1.1

especificación de un origen

$ tcpdump -i eth1 src host 192.168.1.1

especificación de un destino

$ tcpdump -i eth1 dst host 192.168.1.1

Podemos especificar un puerto, tanto de origen como destino

$ tcpdump -i eth1 port 25

Especificación de puerto origen

$ tcpdump -i eth1 src port 25

Especificación de puerto destino

$ tcpdump -i eth1 dst port 25

tcpdump es un herramienta en línea de comandos cuya utilidad principal es analizar el tráfico que circula por la red. Permite al usuario capturar y mostrar a tiempo real los paquetes transmitidos y recibidos en la red a la cual el ordenador está conectado.

La idea de hoy es aplicar pequeños filtros pero sin dudas los más efectivo para poder visualizar eso que tanto nos interesa, como por ejemplo ver si un host se está conectando al server por un puerto determinado o un protocolo específico.

Filtros por Host

Aqui podemos especificar un host tanto para su origen como destino

$ tcpdump -i eth1 host 192.168.1.1

especificación de un origen

$ tcpdump -i eth1 src host 192.168.1.1

especificación de un destino

$ tcpdump -i eth1 dst host 192.168.1.1

Filtros por Puertos

Podemos especificar un puerto, tanto de origen como destino

$ tcpdump -i eth1 port 25

Especificación de puerto origen

$ tcpdump -i eth1 src port 25

Especificación de puerto destino

$ tcpdump -i eth1 dst port 25

Etiquetas:

Administradores

,

Herramientas

,

Linux

3 de junio de 2014

Google Hack: Cuando nuestra información Privada pasa a ser Pública

Que bueno es volver al mundo de los Hack en Google, es algo de lo que no se puede salir. En estas semanas, estuve trabajando muy duro configurando una DMZ como estrategia y política de Seguridad Perimetral, incorporando varias cosas interesantes en Servidores GNU/Linux, como Bonding en placas ethernet, IDS y Firewall.

Cuando comencé a buscar nuevas formas de mantener documentado toda esta información y la estructura propia de la DMZ, lo primero que se me ocurrió es poner la información en una grilla para mantenerla más organizada, y definitivamente es una forma muy cómoda para tener un panorama rápido de todo el esquema.

Luego por un minuto me puse a pensar, que pasaría si esa documentación cayera en manos de gente con malas intenciones? Seguramente, sería un golpe muy bajo para toda la organización, ya que estamos dejando plasmado todas las conexiones, direcciones de IP públicas y privadas, segmentos de Red, nombre de Servidores, Switch, Routers, etc.

Con toda esta información en la cabeza, comencé a buscar a cuantos administradores más se les ocurrió crear grillas para organizar la información de sus DMZ, con la esperanza de no encontrar tantos archivo colgados en la web, pero definitivamente me equivoqué. Más de 12.000 archivos xls con toda la información lista para hacer OSINT.

Respecto a la búsqueda, muy simple... luego de varias mejoras, me quedé con estas tres palabras claves que reflejan bastante información.

("DMZ" | "Public IP" | "Private IP") filetype:xls

Cuando comencé a buscar nuevas formas de mantener documentado toda esta información y la estructura propia de la DMZ, lo primero que se me ocurrió es poner la información en una grilla para mantenerla más organizada, y definitivamente es una forma muy cómoda para tener un panorama rápido de todo el esquema.

Luego por un minuto me puse a pensar, que pasaría si esa documentación cayera en manos de gente con malas intenciones? Seguramente, sería un golpe muy bajo para toda la organización, ya que estamos dejando plasmado todas las conexiones, direcciones de IP públicas y privadas, segmentos de Red, nombre de Servidores, Switch, Routers, etc.

Con toda esta información en la cabeza, comencé a buscar a cuantos administradores más se les ocurrió crear grillas para organizar la información de sus DMZ, con la esperanza de no encontrar tantos archivo colgados en la web, pero definitivamente me equivoqué. Más de 12.000 archivos xls con toda la información lista para hacer OSINT.

Respecto a la búsqueda, muy simple... luego de varias mejoras, me quedé con estas tres palabras claves que reflejan bastante información.

("DMZ" | "Public IP" | "Private IP") filetype:xls

Etiquetas:

Administradores

,

Configuraciones

,

Google

,

Hack

,

Redes

26 de mayo de 2014

Descubriendo nodos activos en nuestra red

El ejercicio de hoy es buscar una forma simple y rápida de hacer un zondeo por nuestra red buscando los diferentes nodos (Host, Servidores, Impresoras, Switch, etc) que conforman la red.

Desde nuestra terminal y con la ayuda de nmap vamos a realizar una visualización rápida de todos estos dispositivos.

Esta tarea es una de las más importante a la hora de comenzar a realizar una auditoría interna, de este modo, vamos a tener una idea rápida de que tan grande es nuestra superficie de ataque y por que caminos podemos comenzar a seguir.

Para ello vamos a utilizar el comando nmap y su flag -sP conocido como sondeo de Ping con lo cuál nos va a permitir verificar uno a uno dando una mascara de red si estos nodos se encuentran vivos.

$ nmap -sP 192.168.0.0/24

Recuerden que a estos valores como la red y su mascara de red podemos configurarla con los valores de la red que estamos auditando.

Una variante para expresar algunos host determinado, podemos hacer que recorra o pregunta por la existencia de los 100 primeros host

$ nmap -sP 192.168.0.1-100

Estos datos ya podemos ir recopilando a fines de realizar nuestras muestras y observaciones, para ello en una oportunidad ya mostramos como crear reportes con nmap, de esa forma podemos ir verificando si la terminal en la que nos encontramos tiene la posibilidad de “llegar” o visualizar otras direcciones, subredes, etc.

Saludos!

Desde nuestra terminal y con la ayuda de nmap vamos a realizar una visualización rápida de todos estos dispositivos.

Esta tarea es una de las más importante a la hora de comenzar a realizar una auditoría interna, de este modo, vamos a tener una idea rápida de que tan grande es nuestra superficie de ataque y por que caminos podemos comenzar a seguir.

Para ello vamos a utilizar el comando nmap y su flag -sP conocido como sondeo de Ping con lo cuál nos va a permitir verificar uno a uno dando una mascara de red si estos nodos se encuentran vivos.

$ nmap -sP 192.168.0.0/24

Recuerden que a estos valores como la red y su mascara de red podemos configurarla con los valores de la red que estamos auditando.

Una variante para expresar algunos host determinado, podemos hacer que recorra o pregunta por la existencia de los 100 primeros host

$ nmap -sP 192.168.0.1-100

Estos datos ya podemos ir recopilando a fines de realizar nuestras muestras y observaciones, para ello en una oportunidad ya mostramos como crear reportes con nmap, de esa forma podemos ir verificando si la terminal en la que nos encontramos tiene la posibilidad de “llegar” o visualizar otras direcciones, subredes, etc.

Saludos!

Etiquetas:

Administradores

,

Auditoría

,

NMAP

24 de mayo de 2014

UPM TASSI: X Ciclo de conferencias - Auditorias internas

Me quedé con un video para compartir con todos, se trata de nuestro amigo Pablo González de la comunidad flu-project.com en el marco del UPM TASSI: X Ciclo de conferencias.

En este video nos comenta su experiencia como consultor de seguridad en temas de Auditorías Internas, todas aquellas cosas que podemos tener en cuenta, nos deja referencias a varias herramientas y todos sus procedimientos para ejecutar un buen plan de auditoría.

Que los disfruten!

Saludos!

En este video nos comenta su experiencia como consultor de seguridad en temas de Auditorías Internas, todas aquellas cosas que podemos tener en cuenta, nos deja referencias a varias herramientas y todos sus procedimientos para ejecutar un buen plan de auditoría.

Que los disfruten!

Saludos!

Etiquetas:

Administradores

,

Auditoría

,

Video

,

Windows

19 de mayo de 2014

La biblia del Lock Picking

Dentro del mundo de la Seguridad Física encontramos los Accesos Físicos no autorizados, donde el Lock Picking juega el papel más importante.

Desde Septiembre de 1991 fue publicado “MIT Guide to Lock Picking” que hasta ahora sigue siendo considerado como la Biblia del Lock Picking y donde se puede leer temas referidos al funcionamiento de las cerraduras, sus defectos que la hacen vulnerables, diferentes tipos de herramientas y las técnicas de apertura de cerraduras.

En los eventos Hacking es común que se presenten varias charlas sobre apertura de cerraduras con nuevas técnicas, talleres de Lock Picking hasta concursos como es el caso de la Ekoparty.

Saludos!

Enlace | MIT Guide to Lock Picking

Se conoce como Lock Picking (del inglés Lock, que significa cerradura, y pick, ganzúa) a la apertura de cerraduras por medio de técnicas y herramientas especiales que no incluyen la llave original.

Desde Septiembre de 1991 fue publicado “MIT Guide to Lock Picking” que hasta ahora sigue siendo considerado como la Biblia del Lock Picking y donde se puede leer temas referidos al funcionamiento de las cerraduras, sus defectos que la hacen vulnerables, diferentes tipos de herramientas y las técnicas de apertura de cerraduras.

En los eventos Hacking es común que se presenten varias charlas sobre apertura de cerraduras con nuevas técnicas, talleres de Lock Picking hasta concursos como es el caso de la Ekoparty.

Saludos!

Enlace | MIT Guide to Lock Picking

Etiquetas:

Administradores

,

Seguridad Física

17 de mayo de 2014

Introducción a la Calidad de Servicio - QoS

Muy buen fin de semana para tod@s, hoy les quería dejar un video de lo más interesante para poder comprender los fundamentos de Calidad de Servicio o QoS para poder implementarlo en nuestras redes unificadas.

Si somos administradores de redes, es fundamental poder implementar un plan de Calidad de Servicio a los diferentes "servicios" que brinda nuestra red, no es lo mismo el trafico http que el smtp, o que el destinado a dns o VoIP.

Yo desde hace varios años, me dedico a la administración de redes con sistemas GNU/Linux y nuestra herramienta para estas prácticas están dadas gracias a la implementación iproute2 y su suit de aplicaciones como tc, en cuanto a los dispositivos MikroTik que tenemos, también incorporan un software para crear y administrar nuestras políticas de Calidad de Servicio.

Los dejo con este video introductorio...

Saludos!

Etiquetas:

Administradores

,

Linux

,

MikroTik

,

Redes

,

Video

7 de mayo de 2014

Google Hack: buscando archivos compartidos en ownCloud

Hoy nuevamente quería agradecer a la gente de exploit-db.com por haber publicado un nuevo Google Hack enviado en estos días.

En esta oportunidad, aproveche que estoy jugando desde hace tiempo con ownCloud, que es un SaaS Open Source para montar una nube privada y decidí crear una cadena para preguntarle a Google cuantos archivos tenía indexado en sus búsquedas.

inurl:"/public.php?service=files"

Con más de 200.000 archivos indexados con algo que en realidad muchas veces no está muy bueno que se de acceso público.

Luego de un tiempo de utilizar ownCloud, mi recomendación es que si van a compartir un enlace para que otra persona pueda descargar el archivo, utilicen una medida de seguridad de clave compartida, ya que si más adelante el archivo se indexa van a tener que descubrir o romper la clave y por otro lado utilicen una fecha de caducidad para el archivo compartido de entre 5 a 10 días, suficiente tiempo para que la otra persona pueda descargar el archivo.

Que les pareció este nuevo Google Hack?

Saludos!

En esta oportunidad, aproveche que estoy jugando desde hace tiempo con ownCloud, que es un SaaS Open Source para montar una nube privada y decidí crear una cadena para preguntarle a Google cuantos archivos tenía indexado en sus búsquedas.

inurl:"/public.php?service=files"

Con más de 200.000 archivos indexados con algo que en realidad muchas veces no está muy bueno que se de acceso público.

Luego de un tiempo de utilizar ownCloud, mi recomendación es que si van a compartir un enlace para que otra persona pueda descargar el archivo, utilicen una medida de seguridad de clave compartida, ya que si más adelante el archivo se indexa van a tener que descubrir o romper la clave y por otro lado utilicen una fecha de caducidad para el archivo compartido de entre 5 a 10 días, suficiente tiempo para que la otra persona pueda descargar el archivo.

Que les pareció este nuevo Google Hack?

Saludos!

Etiquetas:

Administradores

,

Cloud

,

Google

,

Hack

6 de mayo de 2014

Fuerza bruta con Patator

Buscando una herramienta versátil, simple de usar y modular a la hora de ejecutar algo de fuerza bruta sobre algunos servicios, me encontré con esta excelente tool escrita en #Python llamada Patator.

Esta diseñada de forma modular y permite despertar diferentes parámetros dependiendo del servicio que queremos auditar, de esta forma podemos encontrar los siguientes módulos disponibles:

Patator es la simpleza llevada a la consola de comandos, para buscar todas las combinaciones posibles en usuarios y contraseñas a la hora de intentar ingresar a un servicio, independientemente de las consideraciones que debemos tener y recomendada para el uso en un pentesting.

Esta diseñada de forma modular y permite despertar diferentes parámetros dependiendo del servicio que queremos auditar, de esta forma podemos encontrar los siguientes módulos disponibles:

- ftp_login : Brute-force FTP

- ssh_login : Brute-force SSH

- telnet_login : Brute-force Telnet

- smtp_login : Brute-force SMTP

- smtp_vrfy : Enumerate valid users using the SMTP VRFY command

- smtp_rcpt : Enumerate valid users using the SMTP RCPT TO command

- finger_lookup : Enumerate valid users using Finger

- http_fuzz : Brute-force HTTP/HTTPS

- pop_login : Brute-force POP

- pop_passd : Brute-force poppassd (not POP3)

- imap_login : Brute-force IMAP

- ldap_login : Brute-force LDAP

- smb_login : Brute-force SMB

- smb_lookupsid : Brute-force SMB SID-lookup

- rlogin_login : Brute-force rlogin

- vmauthd_login : Brute-force VMware Authentication Daemon

- mssql_login : Brute-force MSSQL

- oracle_login : Brute-force Oracle

- mysql_login : Brute-force MySQL

- mysql_query : Brute-force MySQL queries

- pgsql_login : Brute-force PostgreSQL

- vnc_login : Brute-force VNC

- dns_forward : Brute-force DNS

- dns_reverse : Brute-force DNS (reverse lookup subnets)

- snmp_login : Brute-force SNMPv1/2 and SNMPv3

- unzip_pass : Brute-force the password of encrypted ZIP files

- keystore_pass : Brute-force the password of Java keystore files

- umbraco_crack : Crack Umbraco HMAC-SHA1 password hashes

Etiquetas:

Administradores

,

Herramientas

Suscribirse a:

Entradas (Atom)

Entradas populares

-

Lamento que te enteres por este medio pero tu pareja te engaña. Hace tiempo estoy saliendo con alguien y me engaño diciendo que no tenia ...

-

El Análisis Forense de computadores y sistemas es una de la rama fascinantes de la seguridad informática que año tras año va tomando más fu...

-

En algún momento hablamos lo simple y práctico que es contactar con reportes reportes web, completos analizadores de Logs que nos permiten m...

-

La idea de este post es dejarle una lista de gente que realmente se dedica a Seguridad Informática y sus temas relacionados, gente apasio...

-

Hoy les quiero compartir un nuevo Webcast parte de la segunda temporada de ElevenPaths Talks . Para esta sesión nos encontramos con Diego Es...

-

Luego de un par de semanas de programacion y algunos commits en los repositorios de GitHub , les quería anunciar la version 1.0 de WPHarde...

-

Esto es parte de las nuevas tecnologías con la que hoy contamos. Solo basta con leer un par de líneas para saber de que estas ideas son las ...

-

Figura 1: 4 consejos para proteger SSH en RouterOS Hace algunos días publiqué un Dork en Google y en Shodan donde nos permite encontra...

-

Excelente investigación por parte de Sheila Berta ( @UnaPibaGeek ) sobre un mecanismo de vulnerar un Android y que dió nombre a su confere...

-

No quería dejar pasar esta oportunidad para celebrar junto a todos los lectores de este, mi pequeño espacio donde me gusta hablar ( escribir...